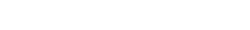

前面我们介绍了谷歌数据中心制冷模块,下图是机房内多排机柜单元和制冷单元的布置示意图,我们可以更为清楚地看到制冷单元和整机柜是如何搭配的。机柜每三个一组,顶部的TOR放在三联柜中间,每三个柜子依次排开。两排机柜间根据实际机柜的功耗和设备类型,搭配不同数量的制冷模块,比如高负荷的计算类机柜列比存储型的机柜列制冷模块要多。如果出现部分区域的设备功耗密度较低,则可以多个三联柜共享稍微少量的制冷模块,这样制冷模块间的顶部空隙可以通过薄铁皮来封闭热通道,如下图标签418所示。如果某个三联柜需要搬迁或者维修,则可以通过底部滚轮灵活由一个运营人员就可容易推走,如下图标签424,但推走后的机柜位需要制冷模块正面的铁皮封板封堵住热通道,以免整个封闭热通道的热气流泄露到机房冷环境中,如下图标签为416的封板所示。

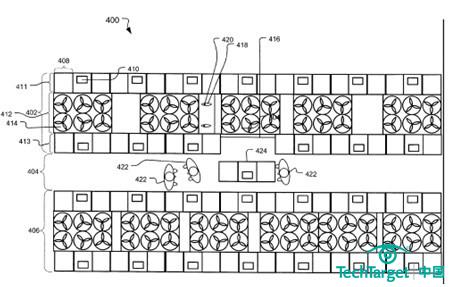

下图是包含了数据中心制冷基础设施的更为详细的剖面图,从这个图我们可以清楚看到冷站604提供的冷冻水通过地板下维护空间内(考虑地板下管路检修维护需要,实际goolge某个项目的地板下高度高达122cm)的冷冻水管614和612,送到机柜上方的制冷模块来带走设备产生的热量。冷站604包括了冷却塔622、板式换热器626、冷机620和水泵624/616等,采用三通阀等设计,可以选择直接冷却或间接冷却。实际建设的时候,冷站也可以是模块化的工厂预制单元,运送到机房现场和对应的多排机柜列对接即可投入使用,真正达到了模块化快速建设的目的。冷站模块间的冗余,也可以通过将这些不同的冷站模块互联到公共接头的主环网中,通过互联互通的环网结构来实现冷站间的冗余,即便某个冷站故障也不会影响整个系统。

实际google的数据中心为了节能运行,会将机房的温度设置得较高,整个机房作为冷通道,整体温度场较为均匀,且较为适合运维人员操作。服务器的进风温度往往高达27摄氏度甚至更高。热通道内的温度则高得多,甚至不适合于运维人员呆在里边,因此服务器全部设计成冷通道前维护。比如热通道内的温度会高达43度以上,经过顶部空调盘管降温后的温度约为25摄氏度,deltaT高达18度,这样顶部空调的风量可大大减少,风扇也可低速运行功耗很低。同时整个机房采用高温27摄氏度运行,冷冻水供水的温度也可以设置在20摄氏度的高位温度,回水温度则约为40摄氏度,这样高温差运行也可大大节省水泵的功耗。如果冷冻水的供水温度可以达到20摄氏度,这样每年制冷主机真正需要开启的时间就非常少,甚至在欧洲的几个数据中心都实现了无冷机运行,而冷机能耗是机房内最大一块,所以这些设计可以大大节约能耗。

我们一直都在努力坚持原创.......请不要一声不吭,就悄悄拿走。

我原创,你原创,我们的内容世界才会更加精彩!

【所有原创内容版权均属TechTarget,欢迎大家转发分享。但未经授权,严禁任何媒体(平面媒体、网络媒体、自媒体等)以及微信公众号复制、转载、摘编或以其他方式进行使用。】

微信公众号

TechTarget

官方微博

TechTarget中国

相关推荐

-

施耐德电气:重视设计和管理,灵活专业打造绿色数据中心

数据中心越来越重要,也同时面临着诸多挑战,如何建设绿色节能的数据中心也成为当前的热门话题。那么如何使数据中心建设更科学、更绿色?

-

台达InfraSuite助宽甸县中心医院构建信息化智慧医院

中国绿色环境整体解决方案专家中达电通携手辽宁省丹东市宽甸县中心医院,为其打造安全可靠、可用性强、绿色节能的数据中心机房,为其构建智慧医院奠定坚实基础。

-

谷歌数据中心IT机柜和空调管路的布局类型

机柜排和横向支管平行的方式下,存在横向支管故障导致整排机柜过热的风险,而机房内横向支管故障或检修的可能性是很大的。如何保证机房内的供冷持续性呢?

-

谷歌数据中心空调系统测试验证过程

前面我们介绍了谷歌数据中心空调系统的特点与建设过程,图9(a)是谷歌空调系统初始阶段的建设流程图,最开始采用租赁的低效率小容量的风冷冷水机组……